En travaillant sur mon article sur les variations dynamiques de fréquence, il m’est venu un truc à l’idée… En plus de varier en fonction de la fréquence et de la tension, la consommation électrique d’une puce dépend aussi de son taux d’utilisation. Du coup, dans les jeux, si on limitait les images calculées par une carte à celles effectivement affichées par l’écran au lieu de faire calculer les images à la carte aussi vite qu’elle le peut, on devrait pouvoir réduire le taux d’utilisation du GPU, et donc sa consommation. Ça tombe bien, la possibilité de limiter existe, via le V-Sync, il suffit donc de vérifier si ça marche…

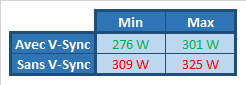

Pour ce faire, j’ai utilisé mon bon vieux wattmètre et j’ai fait tourner le mode benchmark de F1 2013 en mesurant la consommation minimale et maximale durant le test (mon wattmètre ne donne malheureusement pas la moyenne). Le résultat est sans appel :

La consommation maximale avec V-Sync est inférieure à la consommation minimale sans V-Sync… Bon bien sûr ceci n’est pas applicable dans tous les jeux : pour que le V-Sync ne provoque pas de chute de framerate, il faut que la carte graphique soit capable d’assurer les 60 images par seconde tout le temps (du moins tant qu’on ne dispose pas de G-Sync ou de FreeSync), sans quoi le framerate chute directement à 30, puis 20, puis 15…

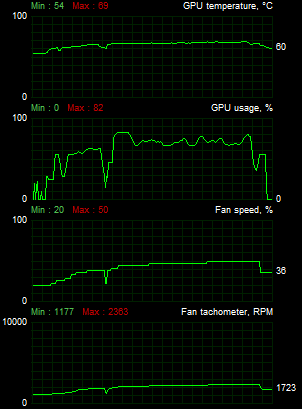

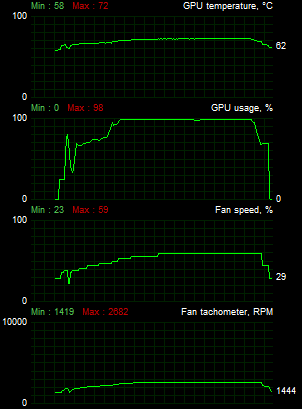

Et qui dit baisse de consommation dit aussi baisse de température et baisse de bruit, ce qui se vérifie bien à l’oreille ou via un outil de monitoring :

Le gain est de l’ordre de 5°C sur la température durant le jeu. À part un petit pic à 69°C, elle s’est stabilisée à 67°C avec V-Sync contre 72°C sans, tandis que le ventilateur s’est limité à 2360 RPM avec V-Sync contre 2680 sans.